Was macht Wan 2.2 anders als Wan 2.1?

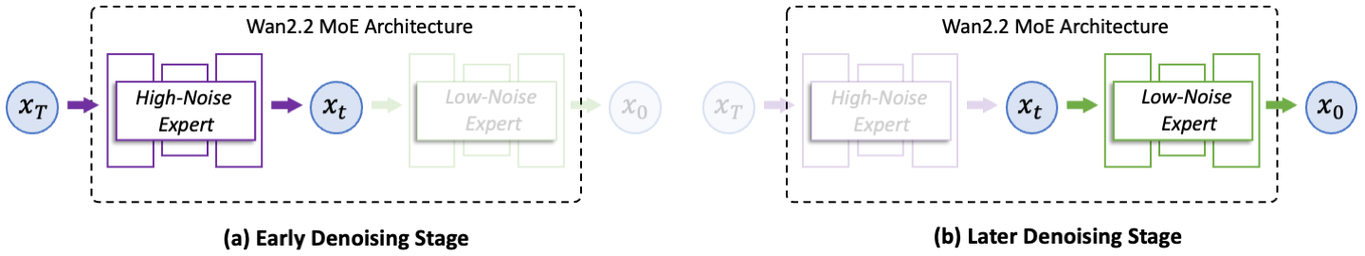

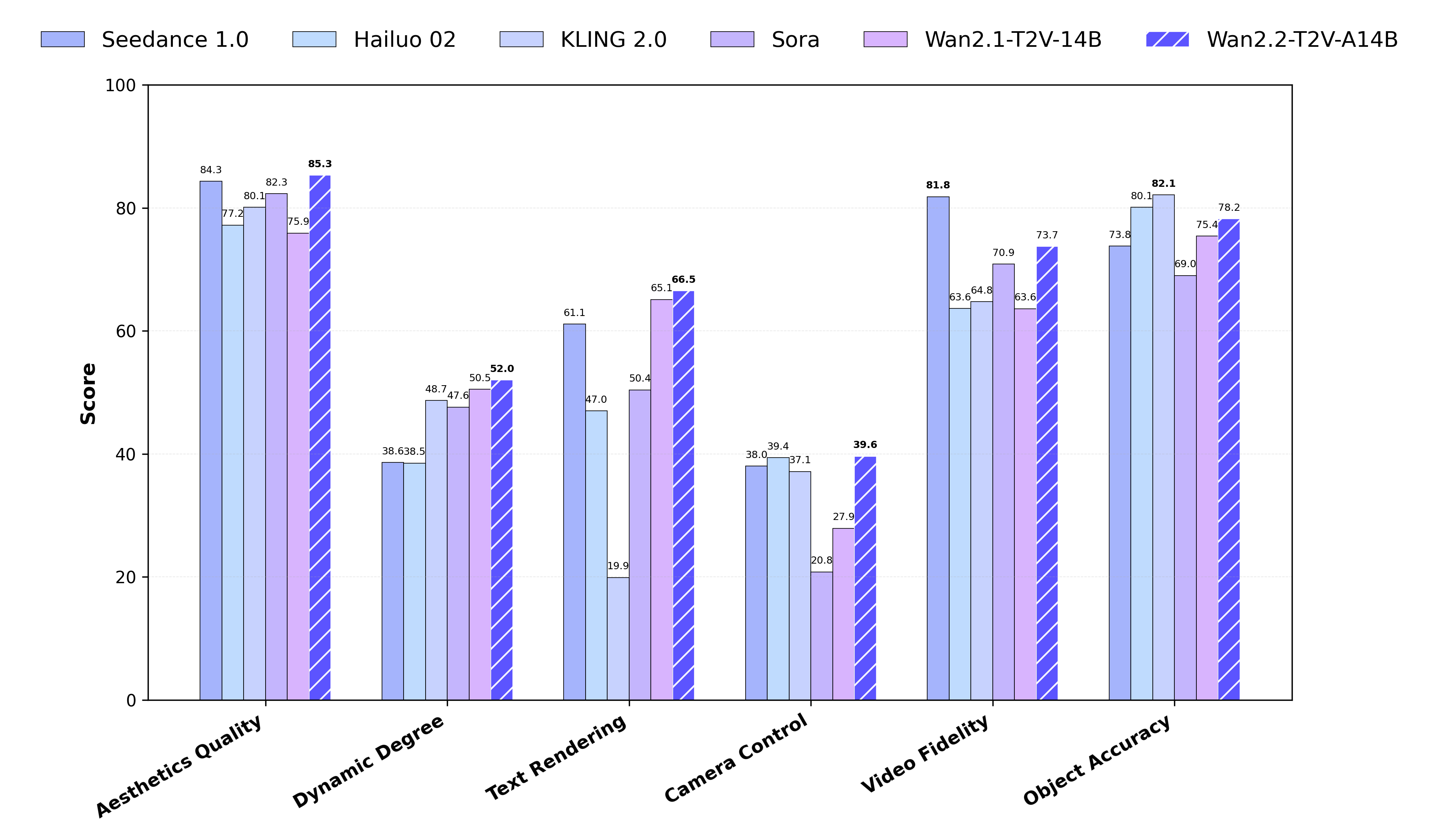

Wan 2.2 ist ein next-generation KI-Video-Generator, entwickelt von Wan AI, einem Forschungsteam von Alibaba. Speziell für Text-zu-Video- und Bild-zu-Video-Aufgaben konzipiert, erzeugt es hochwertige, kinoähnliche Videos mit schnellerer Geschwindigkeit und realistischerer Bewegung. Im Vergleich zu Wan 2.1 verfügt diese Version über eine leistungsstarke Mixture-of-Experts (MoE)-Architektur, die eine reibungslosere Generierung, bessere Prompt-Alignement und stärkere visuelle Kontrolle ermöglicht.